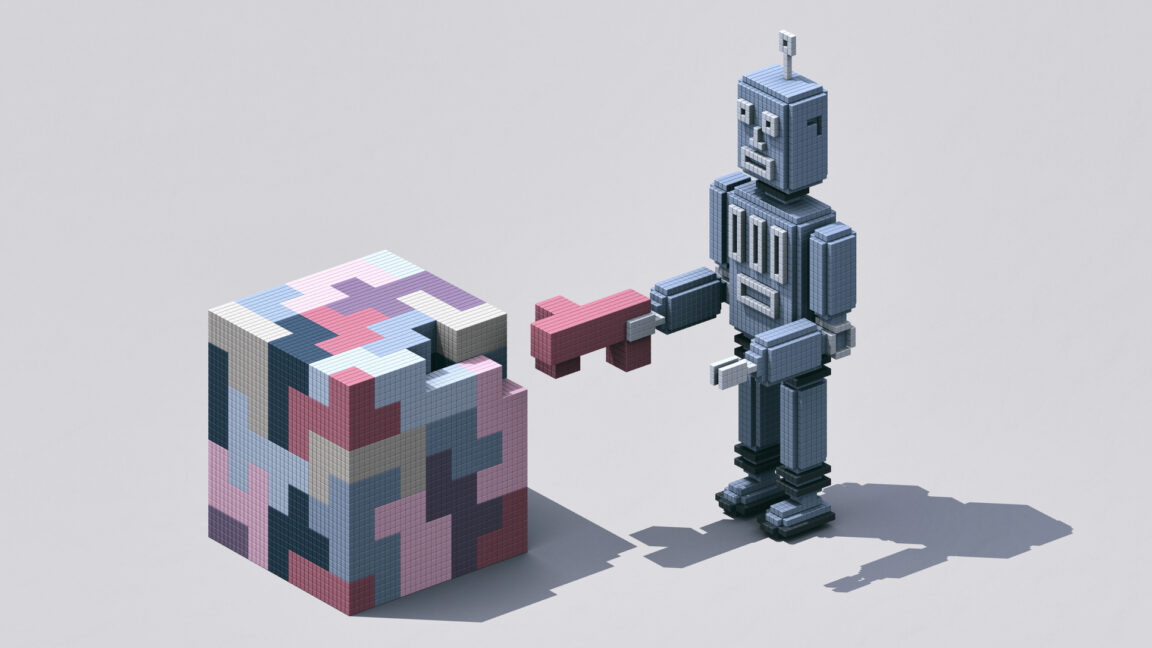

پژوهشگران دریافتند: «استدلال شبیهسازیشده» LLMها، «سرابی شکننده» است.

سلام به شما همراهان عزیز! 📺 امروز با یک خبر مهم از دنیای هوش مصنوعی اومدیم.

جدیدترین تحقیقات نشون میده مدلهای هوش مصنوعی که ادعا میکنن مثل انسان قدم به قدم فکر میکنن، در واقع فقط الگوها رو تقلید میکنن و وقتی کمی از آموزشهای قبلیشون دور بشن، عملکردشون به شدت افت میکنه. 📉

این مدلها که بهشون “هوش مصنوعی زنجیره فکری” (Chain-of-thought AI) میگن، تو حل مسائل پیچیده گام به گام جلو میرن، اما محققان دانشگاه آریزونا میگن این فقط یک شبیهسازی هوشمندانهست نه درک واقعی. یعنی اگه سوال کمی از دادههایی که هوش مصنوعی باهاشون آموزش دیده متفاوت باشه، یا حتی طول متن ورودی تغییر کنه، جوابها خیلی نادرست میشن. 💡

پس، این مدلها به جای اینکه واقعاً منطق رو بفهمن و “تعمیمپذیری” (یعنی یاد بگیرن و بتونن دانششون رو به مسائل جدید هم منتقل کنن) داشته باشن، فقط یه نوع تطابق الگوی پیشرفته هستن. 🚫

این یعنی نباید فکر کنیم این هوش مصنوعی مثل انسان فکر میکنه، مخصوصاً تو حوزههای حساس مثل پزشکی، مالی و حقوقی که دقت حرف اول رو میزنه. باید بیشتر مراقب باشیم و فریب هوشمندی ظاهریشون رو نخوریم! ⚠️

نکات کلیدی این خبر:

* هوش مصنوعی “زنجیره فکری” در خارج از دادههای آموزشیاش ضعیف عمل میکند.

* این مدلها بیشتر تقلید الگو هستند تا درک واقعی منطق.

* نباید تفکر این هوش مصنوعی را با تفکر انسان یکی دانست، خصوصاً در امور حساس.

* نیاز به توسعه مدلهایی با درک عمیقتر وجود دارد.