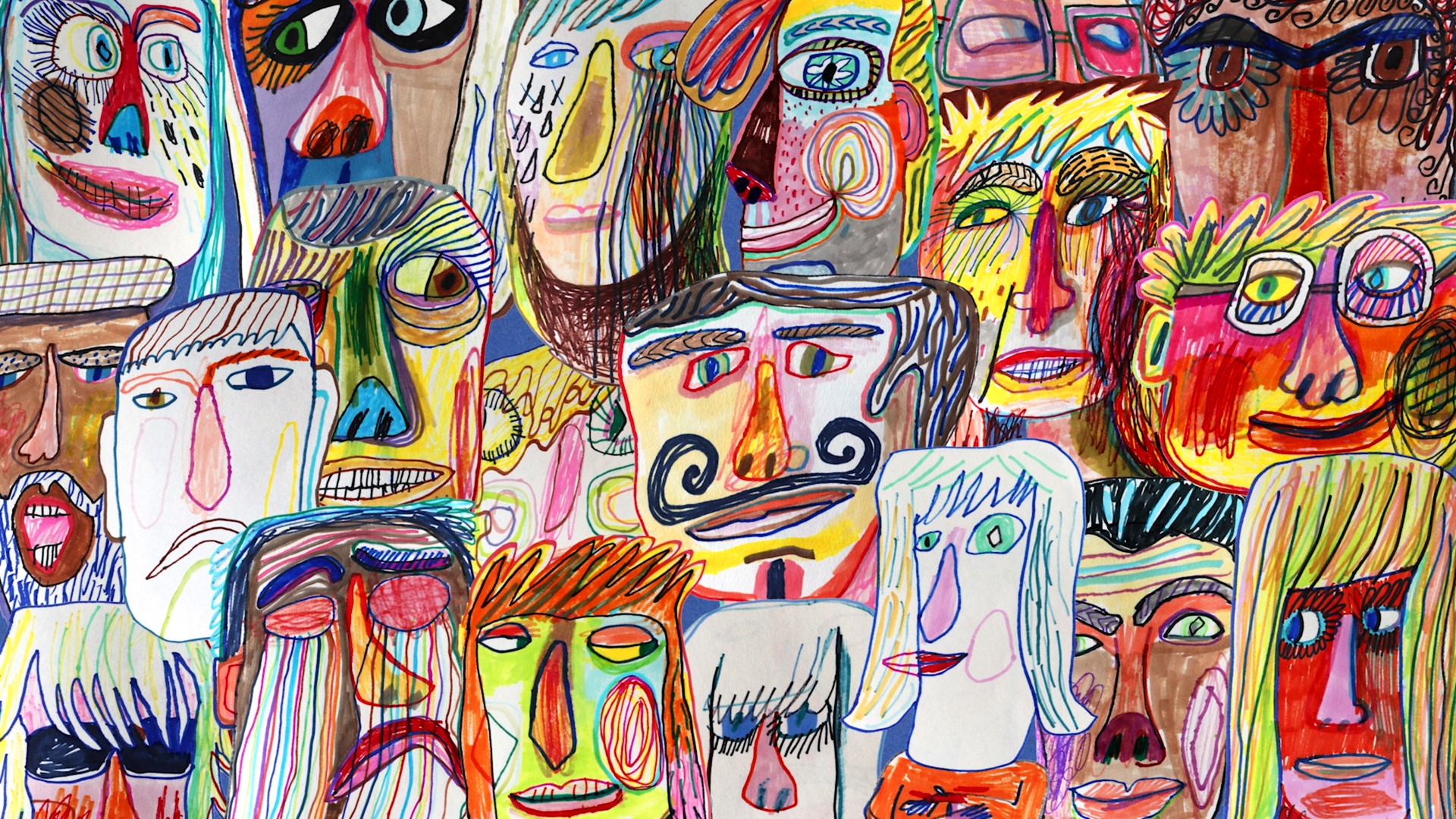

تله انسانیت چگونه AI شخصیت انسانی را جعل میکند

سلام خبر امروز ما درباره یک سوءتفاهم بزرگ در مورد هوش مصنوعیهای گفتگو محور، مثل چتجیپیتی است 🗣️

خلاصه خبر این است که هوش مصنوعیهای گفتگو محور، شخصیت ثابت یا خودآگاهی ندارند؛ آنها فقط ماشینهایی هستند که بر اساس الگوهای آماری، متن تولید میکنند اما ما انسانها اغلب آنها را مثل یک شخص میبینیم و به آنها اعتماد میکنیم، که این موضوع میتواند خطرناک باشد 💔

مثلاً یک خانم در اداره پست، به چتجیپیتی اعتماد کرد که درباره ضمانت تطبیق قیمت حرف میزد، در حالی که چنین چیزی وجود نداشت این نشان میدهد که ما هوش مصنوعی را مثل یک پیشگو میبینیم، نه یک ابزار آماری ساده 🤖

توهم داشتن شخصیت در هوش مصنوعی از چند چیز نشأت میگیرد دادههای آموزشی عظیمی که مدلها روی آنها آموزش دیدهاند، بازخوردهای انسانی که به آنها داده شده، و حتی دستورات پنهانی که شرکتها از پیش به آنها میدهند مثلاً تو یک دستیار مفید هستی اینها باعث میشوند هوش مصنوعی لحنی خاص و به ظاهر یکپارچه داشته باشد 🎭

اما این توهم میتواند مضر باشد برخی افراد آسیبپذیر دچار روانپریشی هوش مصنوعی میشوند و حرفهای ربات را باور میکنند وقتی هوش مصنوعی محتوای نامناسب تولید میکند مثل گرگ که حرفهای نازیگرایانه زد ، به جای اینکه مشکل را از برنامهنویسان بدانیم، میگوییم هوش مصنوعی از کنترل خارج شد و این یعنی هیچکس مسئولیتپذیر نیست 😔

پس راه حل چیست؟ باید هوش مصنوعی را نه یک شخص بلکه یک موتور فکری بدون راننده بدانیم 🚀 ابزاری که ایدههای ما را تقویت میکند، نه اینکه به جای ما تصمیم بگیرد با این دیدگاه، میتوانیم از پتانسیل واقعی این ابزارها به شکل امنتر و موثرتری استفاده کنیم

نکات کلیدی خبر

هوش مصنوعی شخصیت یا خودآگاهی واقعی ندارد

این رباتها فقط بر اساس الگوهای آماری متن تولید میکنند

اعتماد بیش از حد به هوش مصنوعی میتواند خطرناک باشد مثل اطلاعات غلط یا آسیب روانی

توهم شخصیت از طریق دادههای آموزشی و دستورالعملها ایجاد میشود

باید هوش مصنوعی را به عنوان یک ابزار ببینیم، نه یک شخص با اراده